일정 기간 동안 정해진 횟수 이상 유해 게시물 업로드 적발시 삭제

계정 비활성화 알림 기능 도입

계정 비활성화 알림 기능 도입

인스타그램이 보다 안전한 플랫폼 이용 환경 조성을 위해 계정 비활성화 정책을 강화한다고 22일 밝혔다.

기존에 인스타그램은 음란물, 사이버 불링 등 커뮤니티 가이드라인을 위배하는 유해 게시물을 찾아 삭제하고, 계정의 전체 게시물 중 유해 게시물이 일정 비율을 초과할 경우 계정 비활성화 조치를 취했다.

새롭게 강화되는 정책은 일정 기간 동안 정해진 횟수 이상으로 유해 게시물을 올리는 계정을 즉시 삭제하도록 하는 ‘스트라이크 아웃’ 모델이다. 유해 게시물을 반복적으로 올렸다 내리거나, 전체 게시물 수가 방대해 상대적으로 유해 게시물 비율이 낮은 이유로 비활성화 하지 못했던 계정들을 더욱 강력하게 단속할 수 있다.

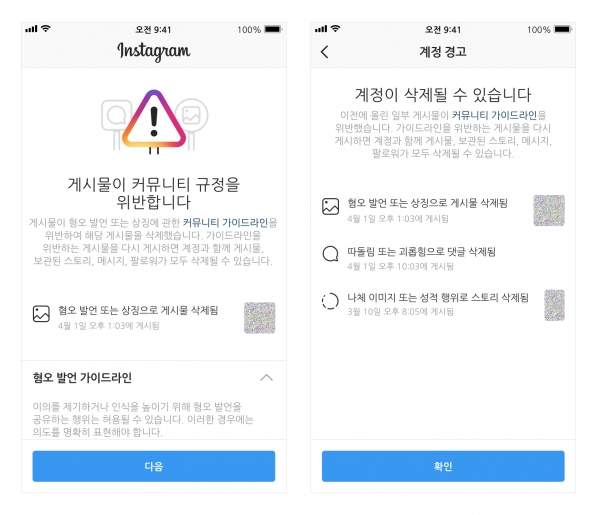

유해 게시물 삭제와 함께 계정 소유자에게 해당 계정이 비활성화될 수 있다는 알림을 띄우는 기능도 새롭게 도입한다. 게시물 삭제가 부당하다고 생각하는 계정 소유자는 해당 알림을 통해 재심사를 요청할 수 있다.

인스타그램은 안전 정책 강화와 함께 지속적인 안전관련 기능 및 기술 개발 투자를 통해 더욱 안전한 플랫폼 조성에 힘쓰고 있다.

지난 9일에는 사이버 불링 근절을 위해 AI 기술을 활용하는 ‘댓글 취소’, ‘제한하기’ 등을 포함하는 새로운 안전 기능 도입을 발표했다.

저작권자 © Brand Brief - 브랜드브리프 무단전재 및 재배포 금지